Jak monitorować widoczność w AI? Zajrzyj do logów serwera!

Informacji na temat tego, jak wyglądają wizyty botów AI na Twojej stronie, musisz szukać w logach serwera. Oczywiście najpopularniejsze narzędzia SEO oferują moduły, które teoretycznie pokazują widoczność np. w ChatGPT, ale warto pamiętać, że to jedynie estymacja. Realne dane o tym, jak boty zachowują się konkretnie na Twojej stronie, dostarczą tylko logi serwera.

Czym są logi serwera? W logach odkładają się wszystkie dane na temat żądań i wizyt na witrynie. Zapisują się tam m.in. dane w postaci user-agent, mówiące o tym, jaki bot odwiedza naszą stronę, na jaką podstronę wchodzi i jak często – to będą dane, które bedą najistotniejsze w kontekście sprawdzania widoczności w narzędziach AI. Jak ułatwić sobie ich analizę?

Zobacz też krótkie video na ten temat od Roberta Smalarza, naszego Senior Web Developera

Screaming Frog Log File Analyser

W pierwszej kolejności, polecamy narzędzie od słynnej SEO-wej żaby. Możecie kojarzyć Screaming Frog jako crawler SEO, ale pod tym brandem funkcjonuje też inne narzędzie – wspomniany Log File Analyser, który bardzo ułatwia pracę z logami.

W narzędziu możemy analizować zarówno zachowania Google bota, jak i botów narzędzi LLM (na czym skupimy się w kontekście tematu dzisiejszego artykułu).

Jak korzystać z narzędzia?

- Krok pierwszy to instalacja narzędzia na komputerze (działa jako aplikacja, nie otwiera się w przeglądarce).

- Przygotuj eksport logów serwera za dany okres, np. ostatni miesiąc. (Instrukcję, jakie formaty plików obsługuje narzędzie, znajdziesz tutaj).

- Następnie utwórz nowy projekt i przeciągnij plik z logami.

- W kolejnym kroku wybierz user-agentów, których chcesz przeanalizować. Możesz wybrać w narzędziu opcję botów AI, jeśli chcesz się skupić tylko na ich analizie.

- Zaimportuj logi i zacznij analizę od zakładki overview, gdzie znajdziesz podsumowanie danych. Następnie zajrzyj do:

- URLs – lista odwiedzonych przez boty stron, statusy HTTP, czas odpowiedzi serwera

- Response Codes – konkretny podział po kodach HTTP. Tutaj wykryjesz np. Błędy 404 lub problemy z serwerem (błedy 5xx)

- User Agents – ta zakładka pokaże Ci informacje z podziałem na zachowania poszczególnych botów

- Directories – które sekcje i katalogi Twojego serwisu są najczęściej odwiedzane przez boty AI

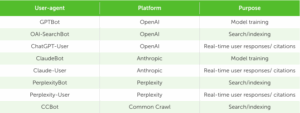

Poniżej znajdują się informacje, które pomogą Ci zrozumieć, w jakim celu bot wchodzi na Twoją stronę. Jak możesz zauważyć, zwykle user-agent z dopiskiem “user” będzie oznaczał odwiedziny strony w celu znalezienia odpowiedzi na zapytanie użytkownika w narzędziu AI.

Źródło: Screaming Frog

Wyczerpującą instrukcję korzystania ze Screaming Frog Log Files Analyzer znajdziesz na stronie narzędzia ScreamingFrog.

Ważne: narzędzie jest płatne. Naszym zdaniem i tak warto skorzystać, nawet jednorazowo, żeby wyłapać najważniejsze problemy, natomiast poniżej kilka tańszych alternatyw.

Alternatywne narzędzie: Google Colab i Phyton

Darmowa alternatywa, nieco trudniejsza w obsłudze, to wykorzystanie narzędzia Google Colab i kodowania z pomocą Phytona. Spokojnie! Nie musisz być zaawansowanym programistą znającym Phytona – narzędzia takie jak Claude.AI mogą Ci pomóc w tworzeniu kodu.

Narzędzie Google Colab

Obrabianie plików z logami w arkuszach Google nie będą możliwe, ponieważ bardzo dużo ważą. Do analizy większych zbiorów danych lepiej sprawdzi się właśnie Phyton. Google Colab to darmowe narzędzie do uruchomienia kodu Phyton. Jest tam już wbudowane narzędzie do pisania kodu z pomocą AI. Spróbuj tam wkleić Twój prompt.

Co powinien zawierać? Opisz dokładnie składnię plików z logami serwera (jakie dane i w jakiej kolejności znajdują się w wierszach). Następnie poproś o przygotowanie skryptów, które z wrzucanych plików z logami serwera będą filtrowały tylko te wiersze, które będą się odnosiły do botów AI, po nazwie user-agent, które najlepiej wylistować (nazwy możesz wziąć z poprzedniej tabelki ze Screaming Frog).

Z odfiltrowanych wierszy za pomocą kolejnego promptu poproś o wygenerowanie skryptu, który przygotuje wykresy, dashboardy, a nawet całe raporty.

Cerber AI – narzędzie Delante

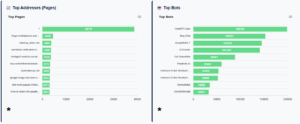

W Delante oferujemy jeszcze prostszą opcję, do tego tańszą niż Screaming Frog. Na potrzeby naszych wewnętrznych analiz logów przygotowaliśmy dedykowane narzędzie autorskie, Cerber AI, którego głównym zadaniem jest właśnie analiza logów serwera i identyfikacja co boty AI robią na stronie i jakie strony “czytają”.

Dzięki CerberAI możemy zweryfikować, czy boty AI chodzą po stronie, a gdzie dokładnie nie docierają i z jakich powodów. To narzędzie pozwala zidentyfikować realne problemy w dostępności strony dla botów AI i szybko je naprawić. Dostęp do narzędzia jest możliwy także dla klientów indywidualnych – skontaktuj się z nami po więcej szczegółów!

d-tags

d-tags